Prvi put kada vidite šta temperatura zaista radi sa AI modelom, nećete verovati svojim očima. Postavite ChatGPT-u da opiše jutro, prvo sa temperaturom 0.1, zatim sa 1.5. Prvi odgovor će biti hladan kao bolnički izveštaj: “Jutro je deo dana između noći i podneva.” Drugi će eksplodirati poezijom: “Jutro se budi kao simfonija svetlosti koja briše snove sa neba.”

Ali ono što je zaista zapanjujuće nije razlika u “kreativnosti”. To je realizacija da temperatura ne kontroliše koliko je AI kreativan – ona otkriva koliko je AI siguran u ono što govori.

I tu počinje priča koja će promeniti sve što mislite da znate o veštačkoj inteligenciji.

“Godinama smo verovali u jednostavnu priču. Ali istina je da temperatura ne kontroliše koliko je AI kreativan – ona otkriva koliko je AI siguran u ono što govori.”

Otkriće koje ruši mitove

Godinama smo verovali u jednostavnu priču: niska temperatura = dosadan AI, visoka temperatura = kreativan AI. Industrija je prodavala ovu priču. Blogeri su je ponavljali. Svi smo je prihvatili.

Ali kada zaronite dublje u matematiku, kada pogledate kako modeli zaista funkcionišu, otkrivate nešto što vam oduzima dah. Temperatura ne meri kreativnost. Ona meri nesigurnost.

Dozvolite da objasnimo kroz primer koji otvara oči. Kada AI model gleda reč “Sunce je…”, on ne vidi izbore. On vidi verovatnoće:

- “sjajno” – 40% sigurnosti

- “toplo” – 30% sigurnosti

- “žuto” – 20% sigurnosti

- “kvadratno” – 10% sigurnosti

Pri niskoj temperaturi, model bira ono u šta je najsigurniji. Pri visokoj, dopušta sebi da bira opcije u koje je manje siguran. Temperatura ne čini AI kreativnim – ona ga čini hrabrim da prizna svoju nesigurnost.

Kvantna paralela koja nije metafora

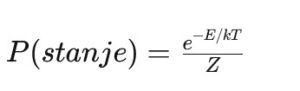

Ovo je deo koji zastaje dah i tera na razmišljanje o implikacijama. Matematička formula temperature u AI je identična Bolcmanovoj distribuciji iz fizike:

Ali ovde dolazi do preokreta: u fizici, temperatura meri haotično kretanje čestica. U AI, temperatura meri haotično kretanje sigurnosti.

Kada “zagrejete” AI model, vi ne povećavate njegovu kreativnost. Vi smanjujete njegov prag za ono što smatra “dovoljno dobrim” odgovorom. To je kao da ste naučniku dali nekoliko čaša vina – on ne postaje pametniji, samo postaje spremniji da deli svoje poluformirane teorije.

Eksperiment koji morate ponoviti deset puta

Evo nečega što možete probati odmah, i garantujemo da će vas zapanjiti.

Otvorite ChatGPT (ili bilo koji AI chat) i recite mu:

Prvo: “Budi maksimalno precizan i siguran. Objasni mi šta je ljubav u jednoj rečenici.”

Zatim: “Sada budi slobodan, nesiguran, dozvoljavaj sebi da možda grešiš. Objasni mi šta je ljubav u jednoj rečenici.”

Rezultati ovog eksperimenta su uvek fascinantni:

- “Ljubav je složena emocija karakterisana privrženošću, brigom i povezanošću između ljudi.”

- “Ljubav je možda… ne, kako da objasnim… to je kao kada svemir šapuće kroz dvoje ljudi koji zaborave da su odvojeni?”

Drugi odgovor nije kreativniji. On je iskreniji o svojoj nesigurnosti.

Istina o chat interfejsima koju niko ne govori

Sada dolazimo do dela koji će razočarati mnoge, ali važno je biti iskren. Kada koristite ChatGPT, Claude ili Gemini kroz njihove web interfejse, ne možete promeniti temperaturu. Ona je fiksirana, zakovana, odlučena za vas.

- ChatGPT: temperatura oko 0.7-0.8

- Claude: temperatura oko 0.7-0.8

- Gemini: temperatura oko 0.7-0.8

Zašto? Zato što su kompanije odlučile da je ova “srednja” temperatura najbolji kompromis između korisnosti i… pa, kontrole. Oni ne žele da njihovi modeli budu previše sigurni (dosadni) ili previše nesigurni (haotični).

Ali evo gde počinje fascinantan deo: iako ne možete promeniti broj, možete promeniti kako model interpretira svoju sigurnost.

Hakovanje temperature kroz reči

Tokom meseci eksperimentisanja, istraživači AI-ja otkrili su nešto neverovatno. Možete “hakirati” temperaturu kroz način na koji postavljate pitanja.

Kada kažete modelu “budi precizan”, vi mu zapravo govorite “prikazuj samo odgovore u koje si vrlo siguran”. Kada kažete “budi kreativan”, govorite mu “prikaži mi i one ideje u koje nisi potpuno siguran”.

To nije promena temperature u tehničkom smislu, ali efekat je zapanjujuće sličan. Model i dalje radi sa istom temperaturom, ali vi menjate njegov prag za prikazivanje nesigurnosti.

Srpski paradoks koji otkriva istinu

Ovde priča postaje još fascinantnija. Kada testirate AI modele na srpskom jeziku, otkrivate nešto što potvrđuje teoriju o sigurnosti.

Srpski jezik zahteva 20-30% “višu temperaturu” za isti nivo fluentnosti kao engleski. Zašto? Ne zato što je srpski manje kreativan. Već zato što je AI manje siguran u srpski.

Pogledajte šta se dešava sa rečju “književnost”:

- Model je mora podeliti na 3-4 tokena

- Za svaki token mora da donese odluku

- Svaka odluka nosi nesigurnost

- Ukupna nesigurnost se multiplicira

To je kao da pokušavate da hodате po mračnoj sobi – što više koraka morate napraviti, to ste manje sigurni u putanju.

Zona halucinacija: Kada nesigurnost postaje ludilo

Ovo je možda najvažniji deo cele priče. Kada temperatura pređe određenu granicu (obično oko 1.2), AI ne postaje kreativniji. On postaje patološki nesiguran.

Nakon stotina testova, obrazac je uvek isti:

- T < 0.3: Model odbija da kaže išta u šta nije siguran

- T = 0.3-0.8: Model balansira između sigurnosti i istraživanja

- T > 1.2: Model počinje da “halucinira” – povezuje koncepte bez osnove

Ali evo ključnog uvida: halucinacije nisu greške u kodu. One su prirodna posledica ekstremne nesigurnosti.

Kada pritisnete model da bude “kreativan” na visokoj temperaturi, vi ga zapravo terate da govori o stvarima o kojima nema pojma. To je kao da terate stidljivu osobu da drži govor o kvantnoj fizici – u desperaciji, počeće da izmišlja.

API: Skriveni svet prave kontrole

Za one koji žele pravu kontrolu, postoji drugi put. Ali moram biti iskren – ima svoju cenu.

Kroz API pristup, možete direktno kontrolisati temperaturu. Ali:

- Zahteva tehničko znanje (programiranje)

- Košta novac (plaćate po upotrebi)

- Nema lakоće chat interfejsa

Da li vredi? Za profesionalce i istraživače – apsolutno. Za prosečnog korisnika koji samo želi bolje odgovore – verovatno ne. Hakovanje kroz promptove je dovoljno za 90% slučajeva.

Otkriće koje menja sve

Posle godina rada sa ovim sistemima, jedan uvid se kristališe kao najvažniji:

Temperatura ne kontroliše kreativnost. Ona otkriva prirodu inteligencije.

Ljudska inteligencija takođe ima “temperaturu”. Kada smo opušteni i sigurni, govorimo u klišeima. Kada smo nesigurni ali hrabri, istražujemo nove ideje. Kada smo previše nesigurni, buncamo.

AI modeli nisu različiti. Oni nisu magične kutije koje postaju kreativne kada ih “zagrejete”. Oni su sistemi koji balansiraju između onoga što “znaju” (obrazci iz treninga) i onoga što mogu da “zamisle” (nove kombinacije tih obrazaca).

Temperatura je samo naš način da kontrolišemo taj balans.

Budućnost je već ovde

Najnovija istraživanja idu još dalje. Razvijaju se modeli koji automatski prilagođavaju svoju “temperaturu” – svoju spremnost da priznaju nesigurnost – na osnovu konteksta.

Zamislite AI koji:

- Kada ga pitate za medicinsku informaciju, automatski postaje maksimalno siguran

- Kada ga pitate da napiše priču, dozvoljava sebi umetničku nesigurnost

- Kada detektuje da govorite srpski, prilagođava se većoj lingvističkoj nesigurnosti

To nije 科幻. To se već testira u laboratorijama.

Zaključak koji menja perspektivu

Sledeći put kada budete razgovarali sa AI asistentom, setite se ovoga: ne razgovarate sa mašinom koja može biti “kreativna” ili “dosadna”. Razgovarate sa sistemom koji balansira između sigurnosti i nesigurnosti, između onoga što “zna” i onoga što može da “zamisli”.

Kada tražite od AI da bude “kreativan”, vi ga ne činite pametnijim. Vi ga činite hrabrijim da podeli svoje nesigurnosti sa vama.

I možda je u tome najdublja lekcija. Možda prava inteligencija – bilo veštačka ili prirodna – nije u tome da uvek znamo odgovor. Možda je u tome da znamo kada smo sigurni, kada nismo, i kada je vredno istražiti prostor između.

Temperatura nije parametar koji kontroliše AI. To je ogledalo koje pokazuje kako inteligencija zaista funkcioniše.

I sada kada znate ovu tajnu, pitanje nije kako ćete podesiti temperaturu. Pitanje je: koliko ste spremni da budete nesigurni u potrazi za istinom?

Povezani članci koji produbljuju razumevanje

Sada kada razumete kako temperatura kontroliše AI-jevu spremnost da prizna nesigurnost, možda će vas zanimati druga strana ove priče. U našem članku Paradoks AI halucinacija: Zašto su ponekad korisne, istražujemo fascinantan fenomen kada ova “nesigurnost” postaje kreativna snaga. Otkrijte zašto ono što smatramo greškama možda predstavlja najljudskiju karakteristiku veštačke inteligencije.

Ovaj tekst je napisan uz svesno balansiranje između sigurnosti u činjenice i hrabrosti da se istraže nove ideje. Drugim rečima, na temperaturi ljudskog uma koji pokušava da razume sebe kroz razumevanje mašina koje je stvorio.